Ein Gedankenexperiment lädt dazu ein, in Notsituationen über Menschenleben zu entscheiden. Forscher des MIT haben Präferenzen aus aller Welt ausgewertet

Ein Junge sitzt allein im Auto. Der Wagen fährt, ohne dass der Junge ihn lenken würde. Plötzlich versagen die Bremsen. Das Auto rast auf einen Zebrastreifen zu, über den gerade ein Mann geht. Es könnte auf eine Betonbarriere umlenken. Der Mann wäre gerettet, der Junge tot. Bleibt der Wagen auf Kurs, lebt der Junge, und der Mann stirbt.

Solche und ähnliche Fälle sind es, über die man auf der Online-Plattform Moral Machine selbst richten muss. Das Projekt des Massachusetts Institute of Technology (MIT) bietet seit Juni 2016 die Möglichkeit, sich einem guten Dutzend moralischer Dilemmata zu stellen. Ein Artikel des Teams um den MIT-Forscher Iyad Rahwan im Top-Journal Nature hat unlängst die fast 40 Millionen Entscheidungen ausgewertet, zu denen sich Menschen aus allen Teilen der Welt bislang durchgerungen haben.

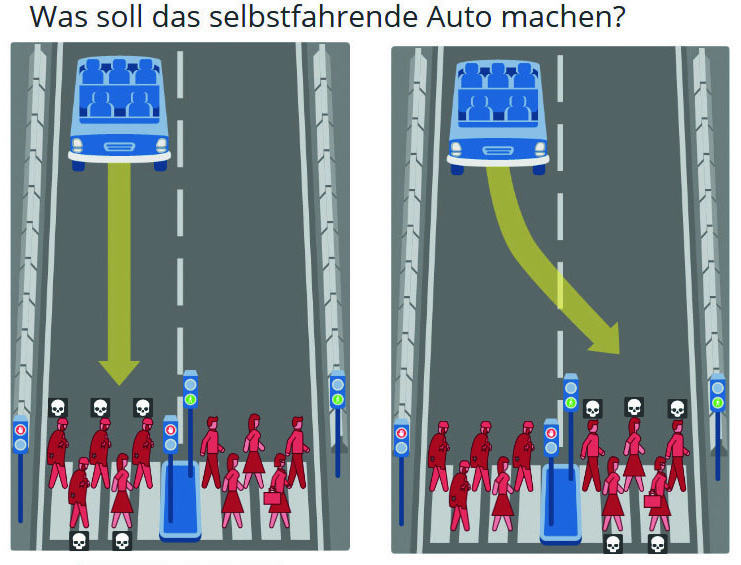

Grundsätzlich ist das Problem immer das Gleiche: Ein selbstfahrendes Auto kann in einer Notsituation nur manche Menschen retten, die jeweils Anderen werden beim Aufprall getötet. Dem unbedarften Nutzer kommt nun die Aufgabe zu, Entscheidungen zu treffen. Und die haben es in sich: Wer darf leben, wer muss sterben?

Das Programm hilft bei der Auswahl, indem es den Todeskandidaten ganz dezent bestimmte Merkmale beilegt. Sollten Sportler den Vorzug vor beleibteren Menschen haben? Kinder vor Älteren? Ärzte und Führungskräfte vor Kriminellen und Obdachlosen? Mit der Ankunft selbstfahrender Autos werden diese Fragen eine Relevanz gewinnen, die weit über Gedankenexperimente am heimischen Computer hinausgeht.

In der Praxis, so Rahwans Team, drängten sich schwierige Abwägungen auf, die öffentliche Debatten erforderten. Denn für fatale Extremsituationen müssten den autonomen Vehikeln gesellschaftlich konsensfähige Leitprinzipien eingegeben werden. Welche das sein könnten, lässt sich anhand des Nature-Artikels nun erahnen. Aus den gewaltigen Datenmengen treten einige klare Muster hervor: Insgesamt wollten die Teilnehmer eher Alte als Junge opfern, eher weniger als mehr Menschen und, wenig überraschend, eher Tiere als Menschen. Dies galt jedoch nur, solange die Menschen gesetzestreu waren – Straftäter haben noch weniger Gnade erfahren als Hunde und nicht viel mehr als Katzen.

Je nach Weltregion können die Resultate allerdings deutlich abweichen. Im „südlichen Cluster“ etwa, das hauptsächlich aus Südamerika besteht, sollten arme beleibte Männer sich in Acht nehmen – hier haben die Teilnehmer klare Präferenzen für Frauen und schlanke Personen. Auch unterscheiden sie scharf nach sozialem Status, sodass Höhergestellte systematisch weniger zu befürchten haben.

Weiterhin variiert die Zahl der Bevorzugten zwischen den Kulturen. Teilnehmer aus individualistisch geprägten Ländern, in denen der Wert und die Autonomie des Einzelnen betont werden, neigen stärker dazu, so viele Menschen wie möglich zu retten. Das schließt sowohl die westliche Welt als auch den Süden ein. In den islamischen und konfuzianischen Ländern des „östlichen Clusters“ ist dies jedoch weit weniger wichtig, ebenso wie die Bevorzugung Menschen mit hoher sozialer Stellung.

Die gleiche Kluft trennt die Kulturräume auch in anderer Hinsicht: In östlichen Ländern, wo Respekt vor Älteren eine hohe Stellung in der Werteordnung einnimmt, kann man sich weit weniger für eine besondere Schonung junger Menschen erwärmen als im Westen und vor allem im Süden. Tatsächlich verlaufen die Präferenzen hier in umgekehrter Richtung – zugunsten der Älteren.

Dennoch dient Individualismus innerhalb der einzelnen Cluster ebenso als Prädiktor für eine Bevorzugung der Jungen wie zwischen den Clustern. Gerade unter den östlichen Ländern geht ein Grad an Individualismus, der höher ist als in anderen östlichen Ländern, damit einher, dass im Gedankenexperiment mehr junge Menschen vor dem Unfalltod bewahrt werden.

Westliche Teilnehmer schließlich haben oft entschieden, nicht ins Geschehen einzugreifen, also den Wagen nicht umzulenken. Der Befund passt zu den Regeln der Ethikkommission zum automatisierten und vernetzten Fahren des deutschen Bundesverkehrsministeriums. Diese hatte bereits 2017 in ihrem Abschlussbericht festgehalten, dass künstliche Intelligenz den menschlichen Fahrer nie ersetzen könne. Sie würde nie imstande sein, sich nach eindeutigen Leitlinien zu richten, um ihr Verhalten in moralischen Zwickmühlen festzulegen, so die Kommission. Auch verbieten ihre Regeln jede Unterscheidung nach persönlichen Merkmalen wie Alter und Geschlecht.

Die Forschergruppe des MIT bewertet den Kommissionsbericht skeptisch. Weil in anderen Kulturen gerade Kinder teils stark bevorzugt würden, seien solche moralischen Ansprüche nur schwer der Öffentlichkeit vor Ort zu vermitteln. Andererseits erheben die Wissenschaftler auch keine moralischen Forderungen nach bestimmten Regelungen. Sie möchten nur ein Bewusstsein dafür schaffen, dass schwierige Fragen in verschiedenen Ländern verschieden beantwortet würden – und dass weltweit verbindliche Regeln daher kaum durchsetzbar seien.

von Lukas Jung

Lukas Jung studiert Philosophie und Politikwissenschaft. Er schreibt seit SoSe 2018 für den ruprecht – vor allem über Wissenschaft, Investigatives und Stadtentwicklung. Seit SoSe 2019 leitet er das Ressort Wissenschaft. ruprecht-Urgestein.